Us et abus de la data

L'utilisation de plus en plus systématique de la statistique dans les analyses divise. Mais celle-ci, loin d'avoir la prétention qu'on lui accorde, souffre plus des interprétations qu'on fait d'elle que de ses propres limites.

Jamais la statistique n’aura été si présente dans le paysage footballistique français, suscitant au passage l’agacement de certains. Paradoxalement, la statistique n’aura jamais été si mal utilisée: mesures biaisés et usages approximatifs contribuent à en faire le vilain petit canard de l’analyse footballistique. Mais peut-on vraiment lui reprocher d’être victime de ceux qui en abusent?

Un outil mal utilisé

Il y a quelques jours, Jean-Michel Larqué s’est fendu d’une sortie dont il a le secret. L’objet de son courroux du jour: la statistique, donc, et plus précisément son omniprésence médiatique. “Les statistiques, ça me gonfle”, a ainsi déclaré le consultant sur RMC Sport. Une manière de dire tout haut ce que beaucoup, sur les réseaux sociaux par exemple, pensent de moins en moins tout bas. Hasard du calendrier, la sortie de Jean-Michel Larqué est tombée quelques jours avant la Sloan Sport Analytics Conference, le grand raout de la statistique sportive, organisé depuis neuf ans maintenant par le MIT Sloan. Et contrairement à ce que l’on pourrait penser, le ressentiment du consultant hexagonal semble y avoir été en partie partagé. “Sport analytics is bullshit now”, titrait ainsi le webzine Deadspin en amont du rassemblement. Qu’un ancien joueur et entraîneur n’apprécie pas les données numériques, cela peut aisément se comprendre; mais que des aficionados de la “data” biberonés au sport US y trouvent à redire est tout de même plus surprenant. Ce qui amène à s’interroger: l’analyse statistique a-t-elle les moyens d’être prise au sérieux?

Car tout le paradoxe est là. Depuis leurs premiers pas en France, les statistiques sont souvent raillées, plus ou moins cordialement, pour leur propension à dire des choses inutiles, partielles et décontextualisées, voire complètement déconnectées de la sacro-sainte “réalité du terrain”. Le constat que nous posions il y a tout juste deux ans de ça n’a d’ailleurs pas pris une ride. Les statistiques ont encore à prouver leur crédibilité auprès d’une certaine frange du foot français – entraîneurs, joueurs et supporters confondus – malgré un nombre croissant de convertis. Il est malheureusement quelque peu regrettable que cette manne reste aujourd’hui, dans ses usages, à un niveau assez futile. Loin d’être de simples gadgets pour médias en panne d’inspiration, les statistiques représentent un précieux outil pour qui souhaite élever le niveau du commentaire footballistique, plutôt que de le laisser aux mains des polémistes de caniveau. Le problème est justement qu’elle n’y parvient pas franchement pour l’instant.

Anciens contre Nouveaux

Le premier handicap de la crédibilité statistique tient en effet dans la vision du football qu’elle représente, plus ou moins malgré elle, depuis son arrivée en fanfare dans le paysage médiatique. Il n’y a qu’à lire en détail la saillie de Jean-Michel Larqué pour s’en convaincre. Loin de s’en prendre à la statistique seule, le consultant y englobe un vaste fourre-tout de “modernité”, mêlant joyeusement les statistiques aux palettes tactiques, alors que celles-ci n’ont a priori pas de rapport direct. Sans surprise, Larqué explique sa position par un facteur générationnel (“Je dois avouer humblement que je ne suis pas de la génération informatique et statistique”), quand bien même cette vision n’est en rien fondée; preuve en est, de nombreux entraîneurs de sa génération ont un usage particulièrement raisonné des données, parmi lesquels son ancien collègue Arsène Wenger, l’une des figures incontournables. Peu lui chaut, et Larqué de finalement conclure en opposant les “qualités humaines” face à celles, forcément impersonnelles, de “l’ordinateur”, figure immanente représentée par l’usage de la donnée à tout va.

Ce manichéisme est une rengaine habituelle, qui surgit inévitablement dans un écosystème lorsqu’émerge la question numérique, avec tout ce qu’elle peut provoquer de mutations intrinsèques. Il était logique et prévisible que des représentants de la “vieille école” s’en inquiètent, et donc s’en offusquent. La culture populaire s’en est d’ailleurs fait le témoin indirect, à travers deux films sortis à quelques mois d’écart, et prenant tous les deux pour sujet le scouting au baseball. D’un côté, le célèbre Moneyball, sorti en 2011 avec Brad Pitt, et qui fait office de tarte à la crème pour tout sujet “data + sport” qui se respecte. De l’autre, la réponse de Clint Eastwood, digne représentant de cette vieille école, à travers Trouble with the curve, sorti un an plus tard. Moins connu que Moneyball, celui-ci met en scène un recruteur vieillissant, qui peine à s’adapter aux nouvelles technologies… Parfois présenté comme l’anti-Moneyball, le film n’a pas connu le succès espéré; il n’en reste pas moins un bon reflet d’une opposition entre deux écoles, celle des Modernistes accros à la stats contre celle des Anciens, défenseurs autoproclamés d’une vision plus “humaine” du sport.

Typologie des données

Il serait malheureux de laisser le débat statistique dans ce type de réductions sommaires. On ne le répètera jamais assez: la statistique n’est pas une question d’âge, ou du moins ne peut-on pas la résumer à cela. Certes, il est plus facile de trouver des data-lovers parmi la jeune génération, dont le regard tactique s’est parfois construit avec les outils de traitement de données disponibles sur Internet (citons par exemple WhoScored, Squawka, ou encore StatsZone). Mais on aurait tort d’y voir une barrière à l’entrée, tant la statistique est en réalité plus accessible qu’on ne le pense. De fait, la majorité des consultants font de la stat’ sans le savoir, tels des Monsieur Jourdain numériques. Pour le comprendre, nous proposons ici une typologie assez sommaire des données disponibles, fondée sur le type d’outil de mesure impliqué. On distinguera ainsi:

- les statistiques “primaires”, ne nécessitant pas d’outil de recueil spécifique. Les scores de match, par exemple, sont des statistiques à part entière. Rappeler qu’une équipe a gagné tant de matches sur tel ou tel score, ou qu’un joueur a reçu tant de cartons jaunes sur les derniers matchs, revient ainsi à mettre en scène des statistiques. Certes très basiques, mais des statistiques quand même.

- les statistiques “secondaires” sont celles qui nécessitent des outils de mesure non-technologiques, car dépassant la capacité de mémoire d’un humain moyen. Il s’agira par exemple de valeurs aisément mesurables à l’oeil, sur une partie: nombre de tirs, nombre d’arrêts, etc.

- les statistiques “tertiaires”, qui forment la génération de statistiques actuelles, impliquent quant à elle un outil de recensement des données, tels que ceux utilisés par Opta pour construire ses bases de données. Bien qu’elles soient recueillies par des agents humains (des petites mains remplissant des tableurs), elles ne pourraient pas décemment s’affranchir de la technologie. On y retrouvera, par exemple, le nombre de passes réalisées par chaque joueur (un nombre difficilement mémorisable sur une partie), avec toutes les variantes possibles: passes vers l’avant ou vers l’arrière, dans sa moitié de terrain ou dans les trente mètres adverses, etc.

- enfin, les statistiques quaternaires, encore balbutiantes. On y rangera l’ensemble des données impliquant des technologies et se passant d’agent humain autre que les joueurs eux-mêmes. Autrement dit, toutes les statistiques mesurées par des capteurs, par exemple des GPS portés par les joueurs, ou des données physiologiques (pouls, etc.). Ces données n’ont, pour l’heure, aucune réelle valeur médiatique.

Flou artistique

Cette typologie, volontairement basique, vise surtout à démontrer que l’explosion actuelle des données n’a rien de véritablement nouveau. En effet, elle s’inscrit dans un processus plus général de décorticage toujours plus poussé du jeu, que l’on autopsie littéralement sous toutes ses coutures: quantitative autant que qualitative. On peut regretter ou non cette évolution, évidemment. Mais on aurait tort de faire de la statistique son bouc émissaire. Malheureusement, le flou artistique qui entoure la data, et ce depuis son arrivée, est loin de contribuer à son acceptabilité. Le cas de la Data Room, jeune et prometteuse émission de Canal+ consacrée, comme son nom l’indique, à cette masse de données footballistique, est à ce titre emblématique.

On pourrait légitimement supposer que l’émission se focalise sur un traitement essentiellement quantitatif du jeu. Au final, et malgré toutes les qualités de l’émission, la Data Room se rapproche davantage d’une Palette-Room modernisée, une resucée de la Palette à Doudouce à la sauce 2.0. Cela n’est en rien reprochable, soit dit en passant. La “bande de geeks” de Margotton fait un excellent travail d’analyse tactique que nous relayons régulièrement dans nos colonnes. Mais il n’en reste pas moins que la majorité des contenus proposés dans une émission standard n’ont qu’un lien très éthéré avec la data au sens strict.

On retrouve là le fourre-tout évoqué dans la sortie de Jean-Michel Larqué, et la donnée fait ici davantage office de porte-drapeau que de véritable outil d’analyse. De fait, elle n’est jamais que le support plus ou moins occasionnel d’un commentaire tactique, basé sur des outils déjà bien ancré dans les moeurs – palettes, positions des joueurs, etc. Mais retournons la question: la statistique a-t-elle les moyens d’être plus que ça? Et surtout, en a-t-elle seulement l’ambition?

Tromperies sur le produit

En réalité, on ne saurait reprocher aux fournisseurs de données de mentir sur le produit qu’ils vendent, d’en exagérer les mérites plus que de raison. Qu’il s’agisse d’Opta (principal partenaire des grands médias français, dont L’Équipe, Canal+ ou beIN Sports, et représenté au sein de la Data Room par David Wall), de Prozone (un peu moins connu en France car essentiellement destiné aux clubs, mais bien implanté outre-Manche), ou d’autres recenseurs de données, le discours a toujours été clair: la statistique seule ne suffit pas, c’est l’interprétation qui compte. Un postulat au parfum d’évidence, mais qui semble être subitement oublié par certains commentateurs lorsqu’ils y font appel.

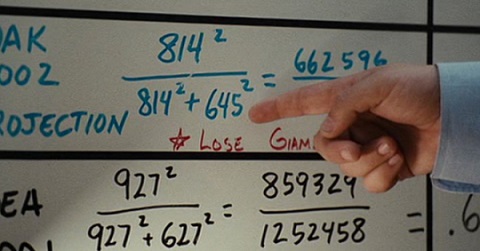

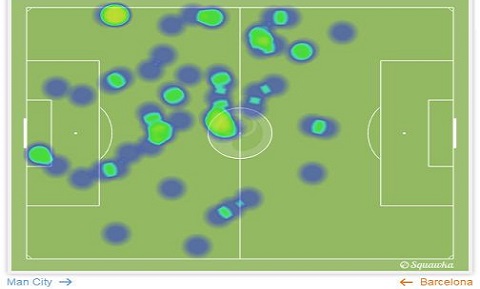

Prenons, par exemple, le cas des “heatmaps” – ou cartes de chaleur en français –, régulièrement utilisées sur les plateaux télé. Elles sont ainsi souvent décrites comme des cartes de positionnement moyen des joueurs. Or, cette présentation s’avère fausse, voire mensongère: les positions représentées sont en effet celles des joueurs lorsqu’ils touchent le ballon, et non celles des joueurs en général. De fait, ces cartes font fi de tous les mouvements invisibles des joueurs, par exemple les appels d’un attaquant, ou le jeu sans ballon d’un défenseur. En présentant ces heatmaps comme une représentation prétendument objective du terrain, les commentateurs se trompent, trompent leur spectateur… et contribuent à décrédibiliser les données dont ils disposent, confortant par là même les arguments d’un Jean-Michel Larqué.

Règles de base

Ce n’est là qu’un exemple parmi d’autres, mais il témoigne de nombreuses approximations observés chaque week-end autour de la donnée. Souvent anecdotiques, parfois plus problématiques, elles rappellent à chaque fois combien la contextualisation d’un chiffre est indispensable. Le problème n’est bien sûr pas exclusif au football, ou même au sport en général. On le retrouve ainsi, presque calqué, dans tous les domaines qui usent et abusent du chiffre comme vérité absolue – le commentaire politique figure évidemment en tête de liste. Et, comme en politique, les réponses à ces biais sont faciles à énoncer. D’abord, rappeler qu’un chiffre n’est en rien objectif, contrairement à ce que l’on pourrait croire. Mesurer un événement sur le terrain, aussi basique soit-il, c’est faire le choix de lui accorder une importance dans l’analyse tactique qui en découlera…

Ensuite, rappeler qu’un chiffre ne vaut pas sans contextualisation ni comparaison, quitte à le marteler encore et encore. Savoir qu’un joueur a fait soixante-dix-huit passes dans un match n’est en rien signifiant; il faut, pour lui donner corps, comparer ce chiffre avec d’autres: nombres de passes moyen des joueurs à ce poste ou contre la même équipe, ratio de passe réussies, etc. Attention toutefois à ne pas pousser les comparaisons vers l’absurde.

Par corollaire, on ne rappellera jamais assez que l’on peut faire dire ce que l’on souhaite aux statistiques… mais que la statistique n’a pas à en porter la culpabilité. Ce sont précisément les scories des commentateurs eux-mêmes qui provoquent le caractère souvent erratique des datas présentées à l’écran, et non l’inverse. Jean-Louis Triaud, en 2011, a dit des statistiques qu’elles étaient “l’analyse du pauvre”. On aimerait rétorquer que c’est plutôt l’inverse, et que les statistiques sont au contraire orphelines de l’analyse.

Ne pas en attendre trop

Enfin, découlant des points précédents, on aimerait ici rappeler que la statistique n’a pas vocation à transformer le football. Elle n’est qu’un outil de compréhension parmi d’autres, et n’a de valeur qu’à partir du moment où elle révèle des éléments “invisibles” à l’oeil humain. Si cela peut rassurer Jean-Mimi, on est encore bien loin de cette situation, et rares sont les statistiques qui permettent d’éclairer le football sous un angle véritablement inédit.

De fait, les statistiques, aussi poussées semblent-elles, restent encore très sommaires. Au mieux permettent-elles d’appuyer le discours d’un commentaire tactique, dont la véritable force résidera davantage dans les palettes et l’observation du placement que dans la batterie de chiffres qui viennent l’accompagner. Surtout, les statistiques actuelles peinent – et risquent de peiner encore longtemps – à retranscrire toutes les réalités du terrain, en particulier le jeu sans ballon. Un récent article de Grantland pointaint ainsi du doigt l’incapacité des datas à “mesurer” le travail de Mesut Özil à Arsenal.

La raison principale est la même que celle évoquée ci-dessus dans le cas des heatmaps: en se focalisant sur le ballon, les statistiques occultent de facto un nombre incalculable de paramètres – repositionnement défensif, marquage et démarquage, appels et contre-appels, etc. Et l’on imagine mal que tous les joueurs de Ligue 1 soient équipés de capteurs GPS au seul profit de quelques analyses tactiques qui, si elles occupent une part croissante du paysage médiatique, n’intéressent au final qu’une frange minoritaire des spectateurs. De fait, il convient de raisonner le débat, et de rappeler aux Jean-Michel Larqué de tous bords que la statistique n’a pas la prétention qu’ils lui accordent. Dans un formidable format long, L’Équipe Explore voyait dans la data une “révolution”; c’était peut-être lui accorder plus d’importance qu’elle ne le demande, du moins tant que son usage ne sera pas mieux maîtrisé.